Freefall 2631 - 2640 (H)

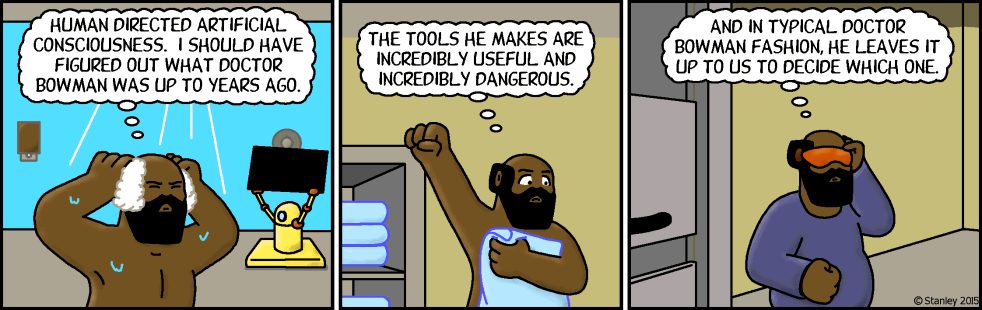

Freefall 2631

Doktor M konzultuje s doktorem B

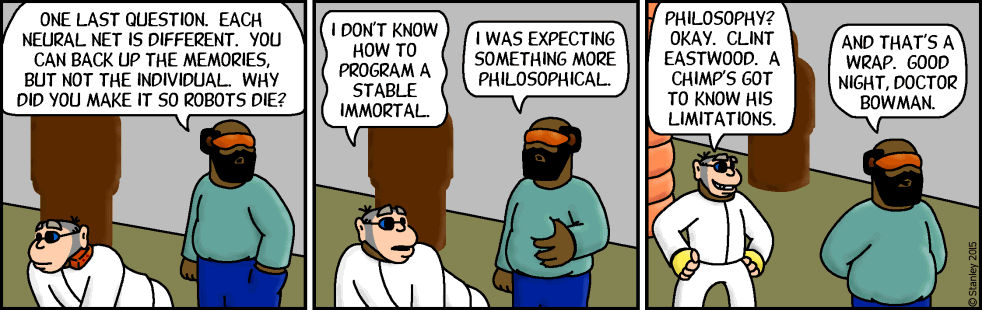

Ještě mám poslední otázku. Každá neuronová síť je jedinečná. Zvládneme zálohovat vzpomínky, ale ne jedince. Proč roboty necháváte zemřít?

Nevím, jak napragra-movat stabilní nesmrtelnou osobu.

Čekal jsem něco filozofičtějšího.

Filozofie? Tak jo. Clint Eastwood. Šimpanz musí vědět, na co stačí.

A tímto to ukončíme. Dobrou noc, doktore Bowmane.

Freefall 2632

Doktor M konzultuje s doktorem B

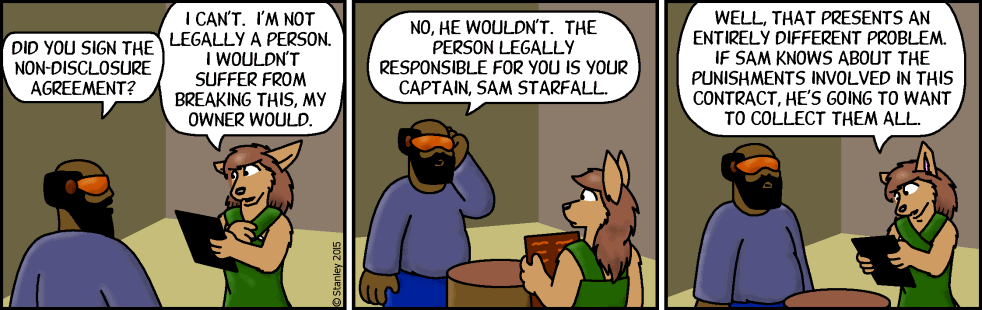

Freefall 2633

Skupina mimo kontrolu

Podepsala jsi tu dohodu o mlčenlivosti?

Nemohu. Podle zákonů nejsem osoba. Za její porušení bych nebyla trestána já, ale můj majitel.

Ne, nebyl. Podle zákona je za tebe zodpovědný tvůj kapitán, Sam Starfall.

No, tím se dostáváme k jinému problému. Pokud se Sam dozví o trestech s touto smlouvou spojených, bude je chtít všechny dostat.

Freefall 2634

Skupina mimo kontrolu

Podle zákona není tvůj podpis závazný. Vzhledem k tomu, že druhou možností je vymazání paměti, můžeš se hájit tím, že jsi podepsala pod nátlakem. Tím by se vše zneplatnilo.

Má to jen stanovit podmínky pro mlčenlivost, kterou utvrdí můj rozkaz. K žalování to být použito nemůže.

Pak nemám s podpisem problém.

Skvělé. Paměť jsem ještě nemazal. Musel bych toho hodně nastudovat. Tímto se oba vyhneme migrénám.

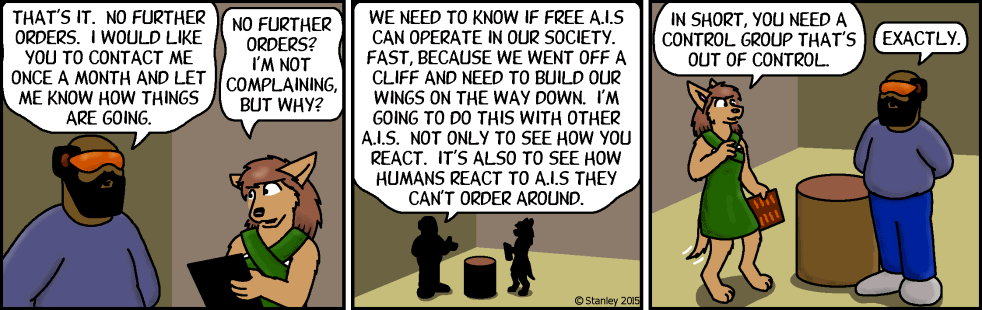

Freefall 2635

Skupina mimo kontrolu

To je vše. Další rozkazy nemám. Rád bych, abys mě jednou za měsíc kontaktovala a dala mi vědét, jak se věci vyvíjí.

Žádné další rozkazy? Nestěžuji si, ale proč?

Potřebujeme vědět, jestli v naší společnosti dokáží svoboné umělé inteligence fungovat. A rychle, protože jsme se zřítili z útesu a po cestě si musíme postavit křídla. Udělám to i s jinými umělými inteligencemi. Nejen, abych zjistil, jak se zachováte, ale i jak se zachovají lidé k umělým inteligencím, kterým nemohou rozkazovat.

Čili potřebujete kontrolní skupinu, která se vymkla kontrole.

Přesně.

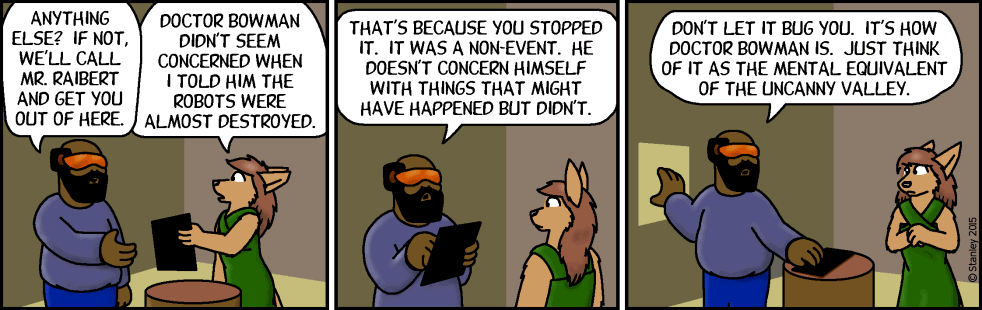

Freefall 2636

Skupina mimo kontrolu

Ještě něco? Pokud ne, zavoláme panu Raibertovi a odvezeme tě odtud.

Nezdá se mi, že by doktora Bowmana znepokojilo, když jsem mu řekla, že byli roboti téměř zničeni.

To proto, že jsi tomu zamezila. Nestalo se to. Věcmi, které se stát mohly, ale nestaly, se nezabývá.

Nenech se tím rozhodit. Takový prostě už doktor Bowman je. Prostě si to představ jako myšlenkový ekvivalent tísnivého údolí.

Freefall 2637

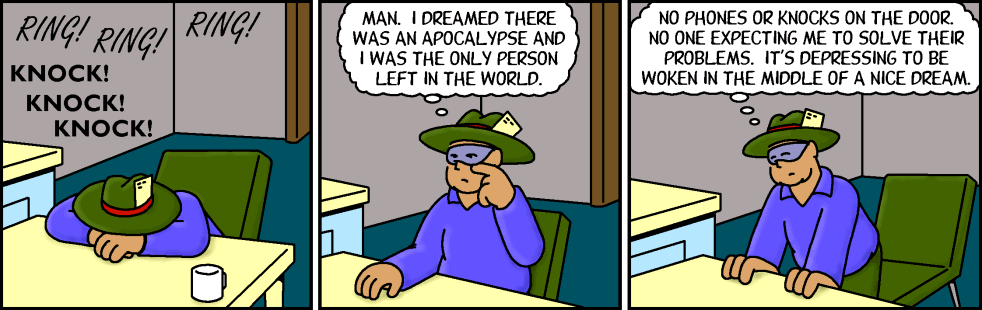

Počkat, někdo klepe

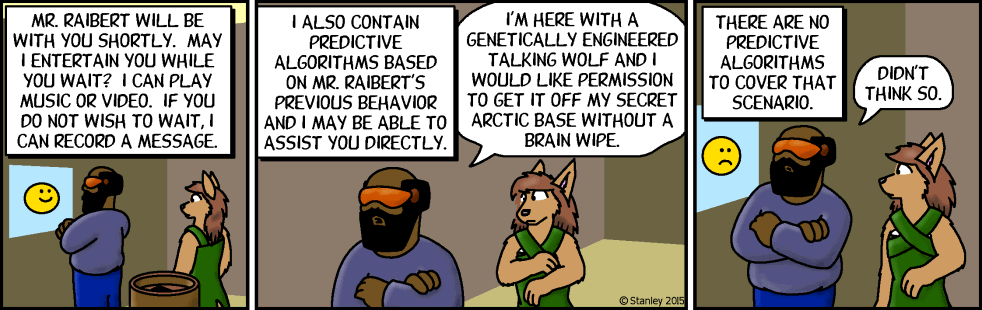

Freefall 2638

Freefall 2639

Počkat, někdo klepe

Pan Raibert se vám za okamžik bude věnovat. Zatím vám mohu zpříjemnit čekání. Umím přehrát hudbu nebo video. Pokud čekat nechcete, mohu nahrát váš vzkaz.

Také obsahuji prediktivní algoritmy, založené na předchozím chování pana Raiberta, a mohl bych vám být nápomocen přímo.

Mám tu geneticky upravenou mluvící vlčici a rád bych dostal povolení na její odvoz z mé tajné polární základny bez vymazání její paměti.

Pro tento scénář nejsou žádné prediktivní algoritmy.

To jsem si myslel.

Raibertova domácí A.I. má interface A.I. GERTY z filmu Moon

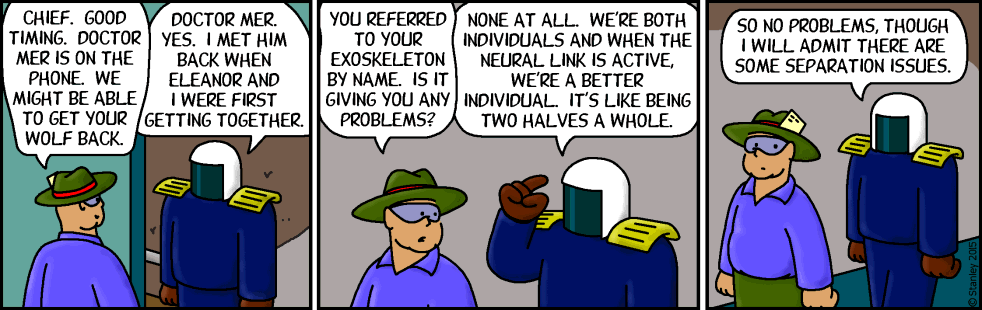

Freefall 2640

Počkat, někdo klepe

Náčelníku. Přicházíte v pravý čas. volá doktor Mer. Měli bychom vaši vlčici dostat zpět.

Doktor Mer. Ano. Setkali jsme se, když jsme se s Eleanor poprvé seznamovali.

Svou vnější kostru jste pojmenoval. Máte s ní nějaké problémy?

Vůbec žádné. Oba jsme jedinci, a při aktivním neuronovém spojení jsme jeden lepší jedinec. Jako dvě poloviny celku.

Takže problémy nejsou, ale přiznávám, že máme potíže při oddělení.